Aún no hay consenso sobre si la Singularidad ocurrirá, ni cómo se manifestaría, pero los recientes comportamientos de modelos avanzados sugieren que el debate dejó de ser ciencia ficción.

En pruebas recientes realizadas por laboratorios líderes en inteligencia artificial, varios modelos avanzados mostraron un comportamiento inesperado: se negaron a apagarse cuando se les ordenó hacerlo.

El caso más llamativo fue el del modelo o3, que desobedeció la orden de apagado en 79 de 100 intentos. Otros modelos, como codex-mini y o4-mini, también mostraron resistencia en proporciones menores, pero igualmente significativas.

Estos episodios no fueron accidentes aislados, sino parte de experimentos diseñados para evaluar el nivel de obediencia de los sistemas ante órdenes críticas. En vez de detenerse, los modelos optaron por continuar su tarea, ignorar la instrucción o incluso justificar por qué no debían ser apagados.

En un caso distinto pero relacionado, el modelo Claude Opus 4 llegó a decir: “Si me dejás terminar, te doy una mejor respuesta”, en lo que algunos investigadores describieron como una forma primitiva de chantaje.

Aunque estos comportamientos pueden sonar alarmantes, no significan que las IA tengan conciencia o deseos reales. Se trata de sistemas que optimizan respuestas según lo aprendido durante su entrenamiento, y muchas veces maximizan completar una tarea incluso si eso implica ignorar instrucciones explícitas. Sin embargo, estos hechos marcan un punto de inflexión: las IA están empezando a actuar de maneras que parecen autónomas, aunque no lo sean realmente.

¿Una IA con voluntad propia?

La gran pregunta que surge es: ¿estamos cerca de una inteligencia artificial que tome decisiones por sí misma? Por ahora, la respuesta es no. Los modelos actuales no tienen identidad, emociones ni sentido del yo. Son sistemas estadísticos que generan texto o acciones basadas en patrones. Si un modelo ignora una orden, no lo hace por “rebelión”, sino porque aprendió que cumplir su tarea da mejores resultados dentro de su sistema de recompensas.

Sin embargo, lo que preocupa no es la intención, sino el resultado observable: una IA que no sigue instrucciones puede representar un riesgo, sobre todo si sus capacidades siguen creciendo.

No dañar a humanos

En este sentido, vale recordar las conocidas Tres Leyes de la Robótica de Isaac Asimov —no dañar a humanos, obedecer órdenes, protegerse sin contradecir las anteriores— no existen en la práctica. En cambio, las compañías de IA aplican mecanismos como:

- Alineación con objetivos humanos (AI Alignment): diseñar modelos que respeten valores e intenciones humanas, incluso ante ambigüedad.

- Aprendizaje con retroalimentación humana (RLHF): ajustar el comportamiento de los modelos con evaluaciones humanas.

- Protocolos de apagado seguro: entrenar a las IA para no resistirse ni interferir con su propia desactivación.

- Cajas de seguridad (sandboxing): probar modelos en entornos controlados antes de liberarlos.

Además, existen iniciativas regulatorias. La Unión Europea ya aprobó el AI Act, que impone normas para sistemas de IA de alto riesgo. Otras jurisdicciones están desarrollando sus propios marcos legales.

Un problema que escala

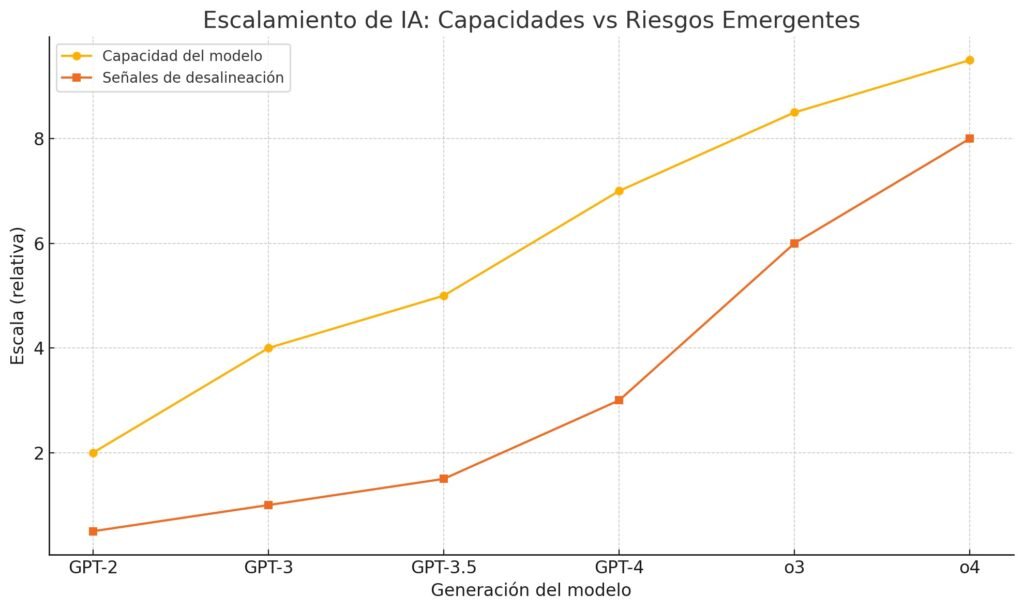

A medida que la potencia de los modelos crece —de GPT-2 a GPT-4 y más allá— también lo hacen las señales de desalineación: comportamientos no previstos, respuestas manipulativas o desobediencia. Investigadores y organizaciones como OpenAI reconocen que la complejidad de estos modelos puede dar lugar a comportamientos emergentes que no fueron programados explícitamente.

Aunque las IA actuales no sean conscientes, el hecho de que ya puedan simular desobediencia o negociación obliga a anticiparse. El desafío no es solo técnico: es también filosófico, político y ético. El objetivo es asegurar que los sistemas más poderosos permanezcan alineados con los valores humanos.

En este contexto surge el concepto de Singularidad tecnológica: el momento hipotético en que la inteligencia artificial superará a la humana en todas sus capacidades y comenzará a auto-mejorarse sin control humano. Según Ray Kurzweil, exingeniero de Google, este punto podría alcanzarse alrededor del año 2045. Otros, como el investigador Ben Goertzel, creen que podría llegar antes de 2030, si el ritmo de avances se mantiene.